機械学習およびディープラーニングと深い関係をもっている手法に、MLP(多層化パーセプトロン)があります。AI市場の急拡大によって用いられることが増えているものの「聞いたことはあるけど、具体的なと概要まではわからない」「もはや聞いたことすらない」という方は多いでしょう。

今回の記事ではMLPの概要や特徴、CNNとの違い、今後の動向などをご紹介します。今回の記事を読むことでMLPが理解でき、およびAIの知見を深めることにつながるでしょう。

MLP(多層パーセプトロン)とは?

MLP(多層パーセプトロン)は機械学習手法のひとつで「ディープラーニングおよびニューラルネットワークの基礎」とされています。ある値を入力として受け取り、特定のルールに基づいて変換し出力する技術です。

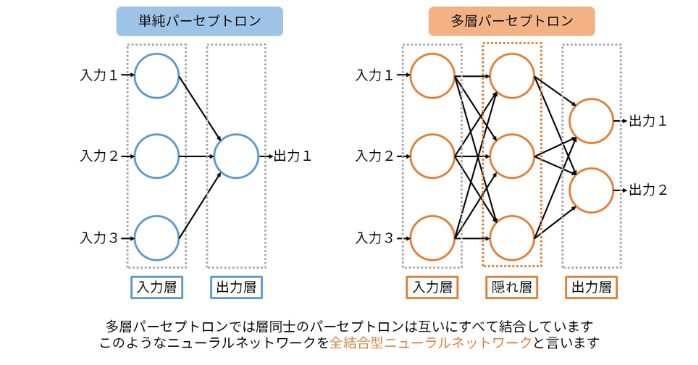

単純な「パーセプトロン」を基にしており、複数の隠れ層(中間層)をもつことが特徴です。各隠れ層は複数のニューロン(ユニット)から構成されており、各ニューロンは前の層からの入力を受け取って重み付けされた値を活性化関数に通して出力します。

図にすると以下のようになります。

引用:多層パーセプトロン

非線形関数を学習する能力をもつため複雑なパターンを学習でき、とくに教師あり学習や教師なし学習、強化学習に適用されます。

学習時には、誤差逆伝播法(Backpropagation)という手法が使われ、ネットワークの出力と目標値との間の誤差を最小化するよう重みを調整していることも特徴です。

そもそも「パーセプトロン」とは何?

1957年にローゼンブラットという研究者によって考案された、単純な形式の人工ニューラルネットワークの一種です。複数の入力を受け取り、重み付けされた合計値を活性化関数にとおし出力を生成する単純な構造をもっています。

一般的なパーセプトロンは次のような手順で動作します。

- 入力と重みの積を合計

- ①の値にバイアス項を加えたものをニューロンの活性化関数として入力

- 活性化関数が、合計された値が一定の閾値を超えた場合ニューロンが発火するか否か決定

本記事の後半でも紹介しますが、パーセプトロンは線形分離可能な問題(たとえば単純な論理回路)を解決するのに適しているものの、非線形分離可能な問題には不向きです。

しかしのちに提案される多層パーセプトロン(MLP)は、非線形問題を解決するための強力なニューラルネットワークとして発展しています。

MLPの特徴・できること

MLPができることは多岐にわたりますが、ここではとくに代表的な以下の3つをご紹介します。

- あらゆるデータの機械学習

- 高精度のデータ予測

- 非線形の分離問題への対応

それぞれ、順を追って見ていきましょう。

あらゆるデータの機械学習

MLPは入力データが画像やテキスト、音声などあらゆる形式であっても適用可能な機械学習です。

「入力データを正確に分類するために正解となるデータを用い、重みを設定してデータ間の誤差を極力減らす動作」を自動で行っているためであり、この動作のことを「誤差逆伝播法(ごさぎゃくでんぱほう)」と呼びます。

高精度のデータ予測

MLPは複雑なパターンや非線形関係をもつデータに対し、高い精度でのデータ予測ができます。多層の隠れ層をもつことで複雑な関数を近似し、高度な特徴を学習できるためです。

時系列でデータを扱えることから「過去のデータに基づく売上や株価の予測」「顧客ニーズの変化」などの用途で役立てられています。また、適切なハイパーパラメータの選択や大量のデータを用いることで、さらなる精度向上が期待できます。

非線形の分離問題への対応

非線形の分離問題に対応できることも、MLPがもつ特徴として挙げられます。「非線形の分離問題」とは、二次元平面にあるグラフの縦・横軸それぞれのデータを直線で分類できない問題のことです。

従来の2層パーセプトロンではこの問題を処理することは不可能でしたが、MLPは複数の複数のパーセプトロンを用いているため処理可能となっています。

これによって画像や音声、テキストなどの多様なデータに対応できているのです。

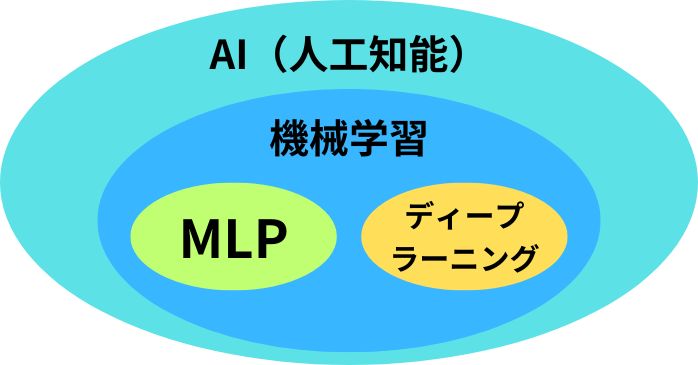

MLPと機械学習やディープラーニングの関係性

冒頭の繰り返しになってしまいますが、MLPとは「ディープラーニングおよびニューラルネットワークの基礎」のことです。つまりディープラーニングは、MLPの進化版です。

そして機械学習とは「データから規則性およびパターンを学習し、未知のデータに対して予測や分類を行う手法の総称」。つまりMLPもディープラーニングも機械学習のひとつということになります(上図参照)。

ニューラルネットワークやディープラーニングの理解に自信がない方は、以下の記事も参考になりますので、ぜひご一読ください。

MLPとCNNはどう違う?

機械学習のMLPとCNNは「多層で処理を行う」という点は共通しているので、困惑する方も多いでしょう。MLPとCNNの違いを一覧にまとめると、以下のようになります。

| 処理工程 | 結合 | |

| MLP | 入力層 ↓ 中間層 ↓ 出力層 | 全結合 |

| CNN | 畳み込み層 ↓ プーリング層 ↓ 全結合層 | 出力に必要なもののみ結合 |

CNNは「畳み込み層」「プーリング層」「全結合層」という特殊な構造をもっていることが最大の特徴です。また結合方法に関してもMLPは全結合ですが、CNNはニューロンの結合を出力するのに必要なものだけ結合する方法に制限されています。

なおCNNについて詳しく知りたい方は、以下の記事も参考になるので、ぜひご一読ください。

MLP技術を活かしたニューラルネットワーク

MLP技術を活かしたニューラルネットワークには、以下のような種類があります。

- CNN(畳み込みニューラルネットワーク)

- RNN(再帰型ニューラルネットワーク)

- LSTM(長短期記憶)

- GAN(敵対的生成ネットワーク)

それぞれ順を追って解説します。

CNN(畳み込みニューラルネットワーク)

CNN(畳み込みニューラルネットワーク)は画像認識や音声認識に特化したニューラルネットワークの一種です。畳み込み演算とプーリング演算により、画像データの特徴を自動的抽出して分類や検出を行います。

「畳み込み層」と「プーリング層」という独特の層によってが画像特徴抽出が行われ、その後に通常のMLPが全結合層として接続されることがMLPとの違い。MLPよりも画像データやシーケンシャルデータの処理に特化しています。

RNN(再帰型ニューラルネットワーク)

RNNは、シーケンシャルデータや時系列データを処理するのに適したニューラルネットワークの一種です。主に自然言語処理や音声認識、動画解析など時間的な情報をもつデータのモデリングに広く使われています。

MLPは層間の接続が前後の層の間でのみ行われるのに対し、RNNは同じ層内のユニット間で再帰的な接続が行われるのが主な違いです。

LSTM(長短期記憶)

LSTM(超短期記憶)は前章で紹介したRNN(再帰型ニューラルネットワーク)の一種であり、長期的な依存関係を学習するのに適したモデルです。通常のRNNで生じる勾配消失などの問題への対策として設計されました。

通常のRNNと比べて複雑なセル構造で、情報の記憶や削除を行うための「ゲート」と呼ばれる仕組みを導入しているのが特徴で、情報の流れの制御や適切なタイミングでの情報保持および破棄を実現しています。

RNNよりも長期的な依存関係を学習しやすいため、自然言語処理や音声認識などのタスクに向いています。

GAN(敵対的生成ネットワーク)

GAN(敵対的生成ネットワーク)は、入力データから敵対的な特徴を用いてデータ生成を行うニューラルネットワークです。生成器(Generator)と識別器(Discriminator)という2つのニューラルネットワークが互いに競い合うように学習するのが大きな特徴です。

生成器は本物のデータに似たデータを生成しようとしますが、識別器はそれを見破ろうとします。この競争が続くうち生成器は本物に近いデータを生成する能力を高め、識別器はそれを見破る能力を高めるというロジックです。

主に画像生成や音声合成、品質改善のタスクで優れた成果を上げています。

MLPの現状の課題

MLPが抱えている課題として、以下のようなものがあります。

- 実用化が難しい分野が多い

- パラメーターの取り扱いが難しい

- ブラックボックス化に陥りがち

それぞれ見ていきましょう。

実用化が難しい分野が多い

MLPの実用化が難しい理由の1つは「勾配消失問題」です。勾配消失問題とは簡単にいうと、学習性能が低下してしまう問題のことをいいます。

具体的には多層のニューラルネットワークでは誤差逆伝播法において逆伝播する際、途中で勾配が極端に小さくなることがあります。これにより層が深くなるにつれて学習が進まず、性能低下を招く可能性が高くなるのです。

この問題によって、実用化に至っていない分野がたくさんあるのが現状です。

パラメーターの取り扱いが難しい

パラメーターの取り扱いの難しさも、MLPの課題のひとつです。パラメーターとはプログラムの処理内容の決定に関わる値のことです。

MLPは多くの隠れ層やユニットをもつことからパラメーターが多く、適切に調整するのが難しいうえパラメーター自体の学習や更新も不可欠なので、なかなか気軽に取り扱うことは難しいのです。

ブラックボックス化に陥りがち

MLPは構造が複雑で多くのパラメーターをもつため、内部の動作が理解しにくい「ブラックボックス」化に陥りがちです。これはモデルが高い性能を発揮してくれる一方「なぜその結果がになったのか」を説明しにくいというデメリットもあります。

いくら正しい結果を返してくれるモデルであっても、どんなロジックでその結果が出たのかという根拠が求められる分野では活用が難しいでしょう。

MLPの今後の動向

ここ十数年でAIおよびIT技術は大きな発展を遂げてきました。その代表例として挙げられるのが、ディープラーニングやニューラルネットワークです。

そしてディープラーニングやニューラルネットワークの基盤となっている技術こそがMLPです。MLPはこれから新しく開発される技術にも、基盤として大いに活用されていくことは間違いないでしょう。

また課題であるブラックボックス化への対策としてMLPの内部動作を可視化する手法が研究されたり、他のアーキテクチャとの組み合わせや新しい学習アルゴリズムが開発されることも期待されています。

機械学習のひとつMLPについてまとめ

MLP(多層パーセプトロン)は機械学習手法のひとつで「ディープラーニングおよびニューラルネットワークの基礎」といった位置づけです。

あらゆるデータの機械学習や高精度のデータ予測などが実現でき、MLPの技術は「CNN」や「RNN」など他のニューラルネットワークにも応用されています。

MLPが理解できるとディープラーニングやニューラルネットワークなどさまざまな技術の理解も深まります。AIに興味をもち、MLPを実際に実装などするきっかけとして本記事が役立てられれば幸いです。

AI研究所が運営するAIエンジニア育成講座では、実践で求められるAI分野を体系的に学べるカリキュラムを用意しております。

プログラミング・機械学習・データ分析・アルゴリズム設計をはじめ、初心者がAIを理解するのにうってつけの内容となっていますので、ぜひご検討ください。