こんにちは!AI研究所の石川です。

本日は、ディープラーニング推論エンジン『SoftNeuro®』に関するtopicsです。

株式会社モルフォは、独自開発した世界最速級のディープラーニング推論エンジン『SoftNeuro®』について、新機能としてルネサスエレクトロニクス株式会社の車載用SoC「R-Car」搭載のAIアクセラレーターエンジン「CNN-IP」に対応したことを発表しました。

ディープラーニング推論エンジン『SoftNeuro』について

モルフォ社は「画像処理/AI(人工知能)」の研究開発型企業です。高度な画像処理技術を組み込みソフトウェアとして、国内外のスマートフォン、半導体メーカを中心にグローバルに展開しています。また、カメラで捉えた画像情報をエッジデバイスやクラウドで解析する、AIを駆使した画像認識技術を車載や産業IoT分野へ提供し、様々なイノベーションを先進のイメージング・テクノロジーで実現しています。

モルフォ社のディープラーニング推論エンジン『SoftNeuro』は、主要なディープラーニング・フレームワークに対応し、様々なエッジデバイス環境で高速な処理を実行します。また、画像認識だけでなく音声認識やテキスト解析等にも利用できる汎用的な推論エンジンです。

Intel/Arm CPU向け『SoftNeuro』においては、試用および非商用での利用に限り2021年12月31日まで無料トライアルサービスを実施しています。

「CNN-IP」対応の『SoftNeuro』について

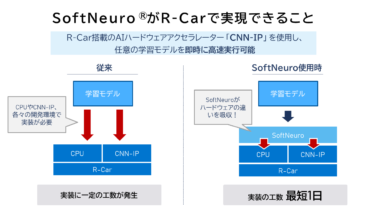

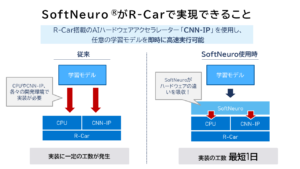

一般的に、車載用途のAI学習モデルは、限られた計算リソースでの高速演算が求められます。R-Carの「CNN-IP」は、その要求に応えることができる高速処理が可能なAIアクセラレーターです。一方で、「CNN-IP」は専用の開発環境を使用し、TensorFlowやONNXベースの任意のAI学習モデルを「CNN-IP」用の形式に変換する必要があり、実装するには一定の工数を要します。

そこで、「CNN-IP」対応の『SoftNeuro』は、専用の開発環境向けに、AI学習モデルを適切な形式に最適化するため、即時に高速な演算を実行することができます。これにより、実装工数を最短1日にまで短縮することが可能です。

実装工数短縮と高速演算を実現する、ルネサス社SoC「R-Car」のAIアクセラレーターに対応したディープラーニング推論エンジン『SoftNeuro®』に注目です!